人工智能预测病人的种族从医学图像

算法的错误教育是一个关键问题;当人工智能镜子无意识的思想、种族主义和偏见的人这些算法生成的,它可以导致严重的伤害。计算机程序,例如,错误地标记黑人被告可能重犯两倍的人是白色的。当一个人工智能作为代理成本用于卫生需求,它错误地命名为黑色的病人比同样生病的白人更健康,更少的钱是花在他们。甚至AI用来写剧本依赖对铸件使用有害的刻板印象。

删除敏感特性的数据似乎是一个可行的调整。但当它不是足够了吗?

偏见的例子自然语言处理boundless-but是麻省理工学院的科学家们调查的另一个重要,主要开发模式:医学图像。使用私人和公共数据集,研究小组发现,人工智能可以准确预测自我种族的病人仅从医学图像。使用胸部x光成像数据,肢体x射线,胸部CT扫描,和乳房x线照片,团队训练深度学习模型认为种族是白色、黑色或Asian-even虽然图像本身包含没有明确提及病人的种族。这是一个壮举即使最老练的医生不能做,也不清楚该模型能够做到这一点。

试图梳理和神秘的“如何”的意义,研究人员进行了大量的实验。调查的可能机制检测,他们看着变量如解剖上的差异,骨质密度、分辨率的图像和更多和检测能力高的模型仍然盛行种族从胸部x光检查。“这些结果最初令人困惑,因为我们的研究团队的成员不能来接近识别一个好的代表这个任务,”论文的合著者说Marzyeh Ghassemi,助理教授麻省理工学院电气工程和计算机科学和医学工程和科学研究所(ime),谁是计算机科学和人工智能实验室的一个附属(权力)和麻省理工学院的贾米尔诊所。“即使你过滤过去医学图像,图像识别,医学图像,深模型保持非常高的性能。关于是因为超人的能力通常是更加难以控制,调节,防止伤害人。”

在一个临床,算法可以帮助告诉我们病人是否适合化疗,决定病人的诊断,或者决定如果ICU的运动是必要的。“我们认为,算法只是看着生命体征或实验室测试,但是他们也看着你的种族,种族,性别,无论你被监禁或甚至如果所有的信息是隐藏的,“Leo安东尼Celi说论文的合著者,主要研究科学家ime麻省理工学院和哈佛大学医学院的医学副教授。“仅仅因为你有不同的群表示算法,这并不保证它不会延续或放大现有差距和不平等。喂养的算法与更多的数据表示不是万能药。本文应使我们停下来真正考虑我们是否已经准备好让AI床边。”

这项研究“人工智能识别病人的种族医学成像:一个建模研究”,发表在《柳叶刀》杂志上的数字医疗5月11日。Celi和Ghassemi写论文20其他作者在四个国家。

设置测试,科学家们首先表明,该模型能够预测比赛跨多个成像模式,不同的数据集,和多样化的临床任务,以及一系列学术中心和患者群体在美国。他们使用三大胸部x射线数据集和测试数据集的模型在一个看不见的子集用于训练模型和一个完全不同的人。接下来,他们训练有素的种族身份non-chest x射线图像检测模型从多个身体位置,包括数字放射显影术,乳房x光检查,评估侧颈椎片,胸部CTs模型的性能是否仅限于胸部x光检查。

团队覆盖了许多基地试图解释模型的行为:不同种族之间物理特性的差异(身体体质,乳腺密度),疾病分布(之前有研究表明,黑色的患者有更高的发病率健康问题像心脏病),具体地点或组织具体的差异,社会偏见和环境压力的影响,深入学习系统的探测能力竞赛当多个人口和病人因素的总和,如果特定的图像区域导致识别竞赛。

真是惊人的出现:模型预测比赛的能力从诊断标签就远低于胸部x光图像模型。

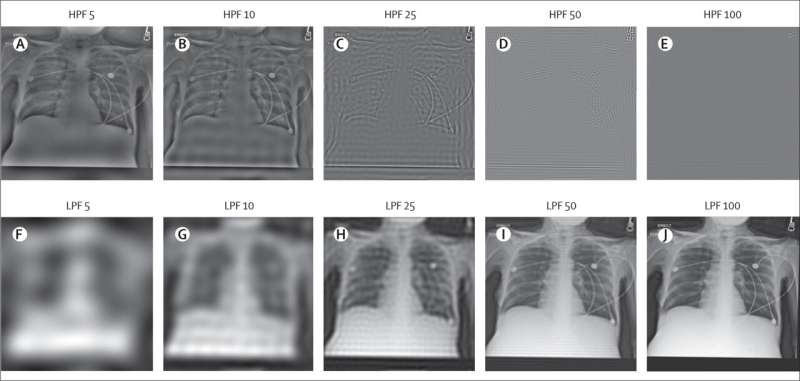

例如,骨质密度测试图像,使用厚骨出现白色的一部分,和薄部分出现更多的灰色或半透明的。科学家认为,因为黑人通常有更高的骨矿物质密度,颜色差异帮助AI模型检测竞赛。减少了,他们剪一个过滤器的图像,所以该模型不能颜色差异。原来切断供应没有让颜色模型仍然可以准确预测比赛。(“曲线下的面积”价值,意义的定量诊断的准确性测试,0.94 - -0.96)。因此,模型的学习特性似乎依赖于图像的所有地区,这意味着控制这类算法的行为提供了一个混乱的,具有挑战性的问题。

科学家们承认有限可用性的种族身份标签,使他们专注于亚洲,黑色,和白色的人群,他们的地面真理是一个自我报告的细节。其他即将到来的工作将包括潜在看着隔离不同的信号图像重建之前,因为与骨质密度的实验中,他们不能占剩余骨组织的图像。

值得注意的是,其他工作由Ghassemi Celi由麻省理工学院学生Hammaad亚当发现,模型也可以确定病人自述种族从临床指出即使这些音符的明确指标的种族。就像在这项工作,人类专家无法准确预测病人临床指出种族相同的修订。

“我们需要把社会科学家。领域专家,这通常是临床医生、公共卫生从业者,计算机科学家和工程师是不够的。医疗保健是一个文化问题,就像它是一个医学问题。我们需要另一组专家参与,并提供输入和反馈我们如何设计、开发、部署和评估这些算法,”Celi说。“我们也需要问数据科学家,在任何勘探的数据之前,是否有差异?哪些病人群体边缘化?这些差异的驱动程序是什么?获得保健吗?主体性的保健提供者吗?如果我们不明白,我们不会有机会能够识别算法的意想不到的后果,我们没有办法可以维护的算法保持偏见。”

“事实上,算法“看到”比赛,正如作者令人信服的文档,可以是危险的。但一个重要的和相关的事实是,当小心地使用时,算法也可以反偏见,“济亚•欧说,加州大学伯克利分校的副教授,他的研究重点是人工智能应用于健康。“在我们自己的工作,由康奈尔大学的计算机科学家艾玛·皮尔森,我们表明,算法,从病人的痛苦经历可以在x射线找到新的膝盖疼痛来源不成比例地影响黑色均由放射科医生不成比例地错过了。就像任何工具、算法可以是一个邪恶的力量还是不错,力量取决于我们,和我们所做的选择,当我们构建算法。”

进一步探索

这个故事是由麻省理工学院新闻(再版web.mit.edu/newsoffice/),一个受欢迎的网站,包括麻省理工学院新闻研究、创新和教学。