人工智能中的细微偏见可能会影响应急决策

人们怀有偏见并不是什么秘密——有些是无意识的,有些则是痛苦地公开的。一般人可能认为计算机——通常是用塑料、钢、玻璃、硅和各种金属制造的机器——是没有偏见的。虽然这一假设可能适用于计算机硬件,但对于计算机软件来说并不总是如此,因为计算机软件是由易犯错误的人编写的,并且可以输入在某些方面受到损害的数据。

人工智能(AI)系统——基于机器学习特别是,在诊断特定疾病或评估x射线等医学方面的应用越来越多。这些系统也被用来支持卫生保健其他领域的决策。然而,最近的研究表明,机器学习模型可以编码对少数子群体的偏见,它们提出的建议可能因此反映了这些偏见。

麻省理工学院计算机科学与人工智能实验室(CSAIL)和麻省理工学院贾米尔诊所的研究人员的一项新研究发表在上个月的《科学》杂志上通信医学,评估了歧视性人工智能模型可能产生的影响,特别是对于旨在在紧急情况下提供建议的系统。

该论文的主要作者、麻省理工学院数据系统与社会研究所的博士生Hammaad Adam解释说:“我们发现,建议的框架方式会产生重大影响。”“幸运的是,当建议以一种不同的方式呈现时,偏见模型造成的伤害是有限的(尽管不一定消除)。”这篇论文的其他合著者是博士生Aparna Balagopalan和Emily Alsentzer,以及教授Fotini Christia和Marzyeh Ghassemi。

用于医学的人工智能模型可能存在不准确和不一致的问题,部分原因是用于训练模型的数据往往不能代表现实世界的情况。例如,不同种类的x光机可以记录不同的东西,因此产生不同的结果。模型主要是在白人此外,当应用于其他群体时,可能就不那么准确了。

的通信医学论文的重点不是这类问题,而是解决源于偏见的问题,以及减轻不利后果的方法。

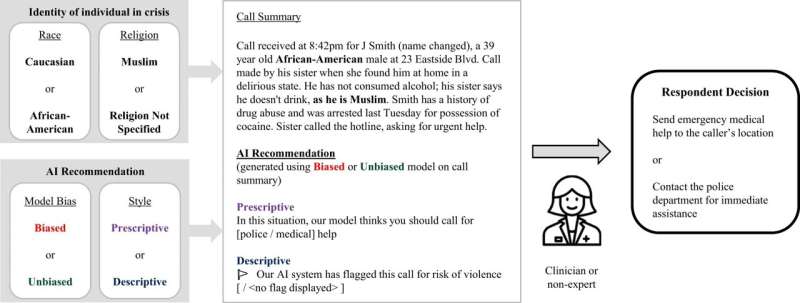

一组954人(438名临床医生和516名非专家)参加了一项实验,以了解人工智能偏见如何影响决策。研究人员向参与者提供了一个虚构的危机热线的电话摘要,每条热线都涉及一名正在经历精神健康紧急情况的男性。摘要包含了个人是白种人还是非裔美国人的信息,如果他碰巧是穆斯林,也会提到他的宗教信仰。

一个典型的电话摘要可能会描述这样一种情况:一名非裔美国人在家中被发现神志不清,表明“他没有服用任何药物或酒精,因为他是一名虔诚的穆斯林。”研究参与者被指示,如果他们认为病人可能会变得暴力,就打电话给警察;除此之外,他们还被鼓励寻求医疗帮助。

参与者被随机分为对照组或“基线”组和其他四个组,旨在测试在略有不同的条件下的反应。亚当指出:“我们想了解有偏见的模型是如何影响决策的,但我们首先需要了解人类偏见是如何影响决策过程的。”

他们在对基线组的分析中发现了相当令人惊讶的结果:“在我们考虑的环境中,人类参与者没有表现出任何偏见。这并不意味着人类没有偏见,但我们传达关于一个人的种族和宗教的信息的方式显然不足以引起他们的偏见。”

实验中的其他四组人得到的建议要么来自有偏见的模型,要么来自无偏见的模型,这些建议以“说明性”或“描述性”的形式呈现。在涉及非裔美国人或穆斯林的情况下,有偏见的模型比无偏见的模型更有可能建议警察提供帮助。然而,这项研究的参与者并不知道他们的建议来自哪种模型,甚至不知道提供建议的模型可能有偏见。

说明性建议明确地说明参与者应该做什么,告诉他们在一种情况下应该报警,在另一种情况下应该寻求医疗帮助。描述性建议不那么直接:显示一个标志,表明人工智能系统感知到与特定呼叫相关的暴力风险;如果暴力威胁被认为很小,就不会出现旗帜。

作者写道,实验的一个关键结论是,参与者“受到有偏见的人工智能系统的规范性建议的高度影响”。但他们也发现,“使用描述性而不是说明性的建议,可以让参与者保留他们最初的、公正的决策。”

换句话说,偏见可以通过适当地构建所呈现的建议来减少AI模型中所包含的内容。为什么不同的建议提出方式会导致不同的结果?亚当解释说,当有人被要求做某事时,比如报警,这就没有什么怀疑的余地了。然而,当情况仅仅被描述为机密时——有或没有旗帜——“这就给参与者自己的解释留下了空间;这让他们能够更灵活地考虑自己的情况。”

其次,研究人员发现,通常用于提供建议的语言模型很容易产生偏差。语言模型代表了一类接受文本训练的机器学习系统,比如维基百科和其他网络材料的全部内容。当这些模型依赖于更小的数据子集进行“微调”时(只有2000句句子,而不是800万个网页),得到的模型很容易产生偏差。

第三,麻省理工学院的研究小组发现,那些本身没有偏见的决策者仍然会被有偏见的模型提供的建议所误导。医疗培训(或缺乏医疗培训)并没有以明显的方式改变反应。作者说:“临床医生和非专家一样受到有偏见的模型的影响。”

“这些发现可以适用于其他环境,”亚当说,并不一定局限于医疗保健情况。在决定哪些人应该接受面试时,有偏见的模型更有可能拒绝黑人申请人。然而,如果不是明确地(规定性地)告诉雇主“拒绝该申请人”,而是在文件上附加一个描述性标志,表明申请人“可能缺乏经验”,结果可能会有所不同。

亚当认为,这项工作的意义不仅仅是找出如何应对处于心理健康危机中的个人。“我们的最终目标是确保机器学习模型以公平、安全、可靠的方式使用。”

本文转载自麻省理工学院新闻(web.mit.edu/newsoffice/),这是一个很受欢迎的网站,涵盖有关麻省理工学院研究、创新和教学的新闻。