医疗人工智能的前景——以及陷阱——正朝着我们走来

手术小组陷入僵局,一名病人躺在手术台上。他们找不到肠破裂的地方。一名外科医生大声问道:“检查一下我们在过去15分钟的视觉画面中是否遗漏了任何肠道部分。”一名人工智能医疗助理负责审查病人过去的扫描记录,并实时突出显示手术过程的视频流。当医生们在手术过程中跳过一个步骤时,它会提醒他们;当外科医生遇到罕见的解剖现象时,它会读出相关的医学文献。

在人工智能的帮助下,所有学科的医生可能很快就能在所有医疗保健的背景下快速查阅患者的整个医疗档案数据以及网上所有发表的医学文献。由于最新一代的人工智能模型,医生办公室的这种潜在的多功能性现在才成为可能。

斯坦福大学工程学院计算机科学教授Jure Leskovec表示:“我们看到医疗人工智能领域正在发生范式转变。”“以前,医疗人工智能模型只能解决医疗保健难题中非常小、狭窄的部分。现在我们正在进入一个新时代,在这个高风险领域,更多的是关于更大的拼图。”

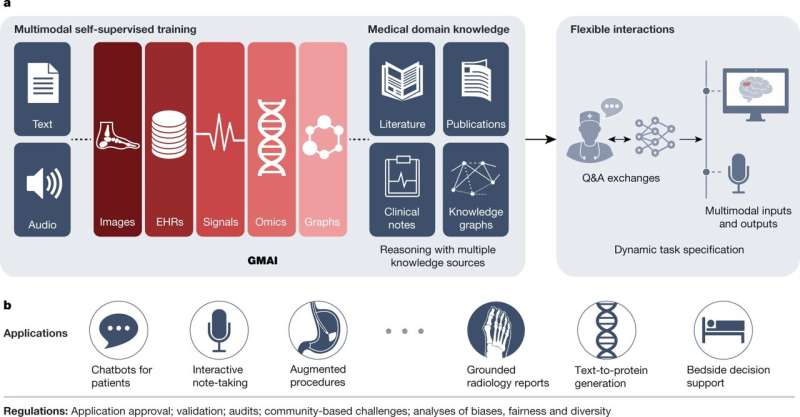

斯坦福大学的研究人员及其合作者将通用医疗人工智能(GMAI)描述为一类新的医疗人工智能模型,这些模型在许多医疗应用程序和数据类型中具有知识、灵活性和可重用性。他们对这一进展的看法发表在4月12日的《科学》杂志上自然。

Leskovec和他的合作者记录了GMAI将如何解释来自成像、电子数据的不同组合健康记录、实验室结果、基因组学和医学文本远远超出了ChatGPT等并发模型的能力。这些GMAI模型将提供口头解释、提供建议、绘制草图和注释图像。

“今天医学领域发生的许多低效和错误都是因为人类医生的高度专业化和缓慢而不稳定的信息流,”共同第一作者迈克尔摩尔说,他是一名医学博士,现在是斯坦福大学工程学院的博士后学者。“通才医疗人工智能模型的潜在影响可能是深远的,因为它们将不仅仅是自己狭窄领域的专家,而是拥有更多跨专业的能力。”

无国界医学

在FDA批准的500多个用于临床医学的人工智能模型中,大多数只执行一两个狭窄的任务,例如扫描胸部x光检查肺炎的迹象。但基础模型研究的最新进展有望解决更多样化和更具挑战性的任务。Leskovec说:“令人兴奋和开创性的部分是,通才医疗人工智能模型将能够摄取不同类型的医疗信息,例如成像研究、实验室结果和基因组数据,然后执行我们指示它们在飞行中完成的任务。”

摩尔继续说道:“我们希望看到医疗人工智能的运作方式发生重大变化。”“接下来,我们将拥有能够完成一千项任务的设备,而不是只完成一项任务,其中一些任务甚至在模型开发期间都没有预料到。”

作者还包括哈佛大学的Oishi Banerjee和Pranav Rajpurkar,耶鲁大学的Harlan Krumholz,多伦多大学的Zahra Shakeri Hossein Abad和Scripps研究转化研究所的Eric Topol,他们概述了GMAI如何处理各种应用,从与患者聊天的机器人到记录,一直到医生的床边决策支持。

作者建议,在放射科,模型可以起草放射学报告,在考虑患者病史的同时,从视觉上指出异常。放射科医生可以通过与GMAI模型聊天来提高他们对病例的理解:“你能突出显示以前图像中没有出现的任何新的多发性硬化症病变吗?”

在他们的论文中,科学家们描述了将GMAI发展成一种值得信赖的技术所需的额外要求和能力。他们指出,该模型必须使用所有个人医疗数据以及历史医疗知识,并且仅在与授权用户交互时引用这些数据。然后,它需要能够与病人进行对话,就像分诊护士或医生一样,收集新的证据和数据,或提出各种治疗方案。

对未来发展的关注

在他们的研究论文中,共同作者阐述了一个能够完成1000个医疗任务的模型的含义,该模型有可能学到更多。“我们认为,医学中通才模式的最大问题是验证。我们怎么知道这个模型是正确的,而不是胡编乱造呢?”Leskovec表示。

他们指出了ChatGPT语言模型中已经发现的缺陷。同样,人工智能生成的教皇穿着设计师设计的蓬松大衣的图像也很有趣。穆尔说:“但如果有高风险的场景,人工智能系统决定生死,那么验证就变得非常重要。”

作者继续这种保护隐私也是一种必需品。摩尔说:“这是一个巨大的问题,因为像ChatGPT和GPT-4这样的模型,在线社区已经找到了破解当前安全措施的方法。”

Leskovec补充说:“破译数据和社会偏见之间的关系也给GMAI带来了巨大的挑战。”GMAI模型需要能够专注于对特定疾病有因果关系的信号,而忽略那些只倾向于与结果相关的虚假信号。摩尔指出,假设模型的尺寸只会变得更大,早期的研究表明,更大的模型往往会展示更多社会的偏见比更小的模型。摩尔说:“这是这些模型的所有者、开发者和供应商的责任,特别是如果他们在医院部署这些模型,就必须确保及早发现并解决这些偏见。”

“目前的技术非常有前途,但仍有很多缺失,”Leskovec同意。“问题是,我们能否找出目前缺失的部分,比如对事实的验证、对偏见的理解以及答案的可解释性/合理性,以便我们为社区提供一个议程,说明如何取得进展,以充分实现GMAI的巨大潜力?”

更多信息:Michael Moor等人,通才医疗人工智能基础模型,自然(2023)。DOI: 10.1038 / s41586 - 023 - 05881 - 4